从蓝牙到XR芯片:AI眼镜的4种计算方案如何分工?

从蓝牙到XR芯片:AI眼镜的4种计算方案如何分工?

当你戴上一副AI眼镜时,它可能在帮你翻译路牌、拍摄Vlog,或是在视野里叠加导航箭头。但你是否想过,这些功能背后到底由谁来“思考”?实际上,AI眼镜的计算能力并非千篇一律,而是像手机、电脑一样,有一套清晰的“分工体系”。目前,市面上的AI眼镜主要依赖4种计算方案,从低功耗的蓝牙芯片到高性能的XR专用芯片,它们各怀绝技,适配不同场景。

方案一:蓝牙音频SoC——“轻量级选手”

代表功能: 语音助手、音乐播放、通话降噪

典型产品: 华为智能眼镜2、界环AI音频眼镜

芯片举例: 恒玄BES2700、高通QCC系列

这副眼镜的核心是一颗蓝牙音频SoC(如高通QCC系列或恒玄BES2700),它像一位“极简派管家”,专注处理音频任务:

- 本地能力:语音识别(如唤醒词“小艺小艺”)、基础降噪算法。

- 云端依赖:复杂指令(如“帮我订一张去北京的高铁票”)需通过手机或云端AI完成。

- 优势:功耗极低(续航10小时+),重量可控制在35克以内,成本仅需百元级。

局限:无法处理图像或AR显示,相当于“能听不能看”。

方案二:蓝牙+外接ISP——“兼职摄影师”

代表功能: 第一视角拍摄、实时物体识别

典型产品: Ray-Ban Meta、闪极A1

芯片组合: 蓝牙SoC(如展锐W517) + 独立ISP(图像处理器)

这类眼镜在蓝牙SoC基础上外挂一颗ISP芯片(如索尼IMX系列传感器配套ISP),分工如下:

- ISP:专职处理摄像头数据,完成1200万像素照片拍摄或1080P视频录制。

- 蓝牙SoC:负责音频和简单AI任务(如语音控制拍照)。

- 云端:AI识别(如“这是什么花?”)仍需上传至Meta的Llama大模型处理。

优势:成本比纯AR眼镜低50%,重量仅40-50克,适合Vlog用户。

代价:续航缩短至2-4小时,且无法本地运行复杂视觉算法。

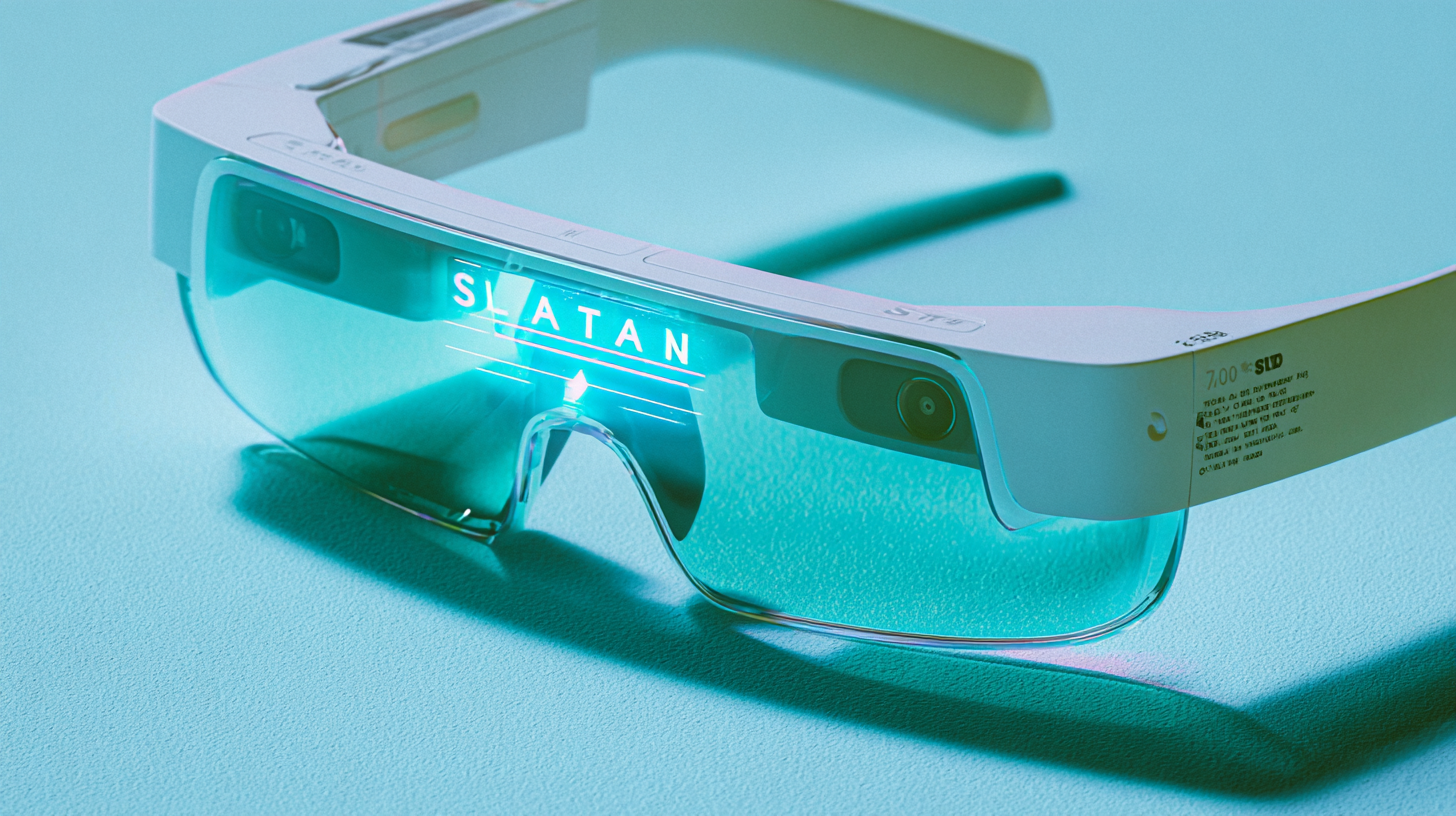

方案三:专用XR SoC——“全能战士”

代表功能: AR导航、3D物体叠加、实时翻译字幕

典型产品: 雷鸟X2、Rokid Glasses

芯片举例: 高通骁龙AR1、骁龙XR2 Gen 2

当眼镜需要显示虚拟信息时,必须依赖XR专用芯片:

- CPU/GPU:渲染3D箭头、虚拟屏幕(如FOV 30°的AR画面)。

- NPU:本地运行AI模型,实现实时翻译(如中文字幕叠加在英文菜单上)。

- ISP:同步处理摄像头画面,用于空间定位(SLAM)。

性能标杆:骁龙AR1可驱动Micro-LED光波导显示,亮度达2000尼特,但需350mAh电池支撑,重量增至60克+。

突破:2024年国产芯片如华为昇腾610开始替代高通,成本降低30%。

方案四:双SoC架构——“性能与续航的平衡术”

代表功能: 全天候AR办公、工业级远程协作

典型产品: 微软HoloLens 2、李未可LAWK S3

芯片组合: 高性能SoC(如骁龙XR2) + 低功耗协处理器(如STM32 MCU)

- 分工策略:

- 主SoC:在需要时启动AR渲染(如展示建筑BIM模型)。

- 协处理器:待机时仅维持传感器数据(如陀螺仪、光线传感器),功耗降低70%。

- 场景案例:工地工程师佩戴HoloLens 2,主芯片仅在查看图纸时全速运行,其余时间由协处理器维持基础功能,续航可达5-6小时。

未来:芯片的“融合”与“下沉”

- 融合:联发科2025年将推出MTK XR Fusion芯片,集成5G、NPU、ISP于一体,单芯片解决所有需求。

- 下沉:Redmi计划2026年发布199元AI眼镜,采用国产展锐W319芯片,仅保留语音和基础摄像功能,推动全民普及。

从蓝牙的“单线程”到XR芯片的“多任务”,AI眼镜的计算方案正像一场精密的交响乐——蓝牙芯片负责低吟浅唱,XR芯片奏响高潮,而双SoC架构则让旋律收放自如。下一次当你戴上眼镜时,不妨想想:此刻为你工作的,是哪一颗“大脑”?

AI/AR 智能眼镜系列文章:

第一篇:AI眼镜的“大脑”:SoC芯片如何让智能眼镜又轻又快?

第二篇:从蓝牙到XR芯片:AI眼镜的4种计算方案如何分工?